... ob es bei einem Gerät für EUR 2.000 normal ist, dass das erste, was ich auf dem Display nach der Einrichtung sehe, defekte Pixel(haufen) auf dem Sensor sind. Da ich das (logischerweise) von DSLRs nicht kenne und mich mit Systemkameras nicht bzw. nur bedingt auskenne,

...

Das hat nichts mit DSLR oder DSLM zu tun. Mit steigender Pixeldichte werden die Strukturen auf den Wafern immer kleiner und somit empfindlicher gegenüber Fertigungstoleranzen und Elektromigration.

Siehe auch Elektromigration:

https://www.elektroniknet.de/halbleiter/der-feind-auf-dem-chip.85242.html

...

Grob würde ich sagen, dass ich dieses Mal zwar mehr "Häufchen" erkennen konnte, sie zwei beim letzten Mal aber etwas größer waren.

...

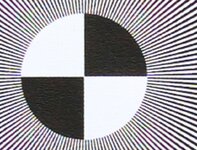

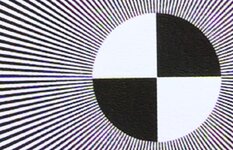

Wenn ein dicker roter blauer oder grüner Punkt auf dem Display erscheint, ist das kein dichter Pixelhaufen, denn wenn das mehrere unmittelbar benachbarte Stuckpixel wären, dann wäre ja nicht nur eine Farbe betroffen, sonder alle drei Farben des Bayerfarbfilters, der dicke Punkt würde dann weiß leuchten. Dass mehre unmittelbar benachbarte Pixel in der gleichen Farbe leuchten - das geht ja wegen dem Bayerfarbfilter nur dann wirklich, wenn die defekten Pixel exakt mit dem Muster des Bayerfarbfilter übereinstimmen, also das gleiche Muster aufweisen - also sehr unwahrscheinlich, also praktisch unmöglich.

...

Genau das ist der Punkt. Ich sehe jetzt einzelne Stellen auf dem Display, die auch auf dem Display selbst ja definitiv größer sind als nur ein Pixel. Was bedeutet das im Umkehrschluss für den Sensor - mehr als 24 defekte Pixel an einer einzelnen Stelle? Oder werden diese ja besonders kontraststarken Stellen dann für die Ansicht auf dem Display sogar noch extra verstärkt, damit sie (als vermeintlich wichtige Details) nicht in der Ansicht auf dem Display untergehen?

...

Das kann nur die Methode der Skalierung für das Display sein.

Eventuell ein weiteres Stuckpixel der gleichen Farbe in der Nähe, beide Stuckpixel rücken durch das Skalieren zusammen.

...

Erst mal danke für die Info, dass das eine 400-%-Ansicht ist (war mir nicht sicher, welche Zoomstufe das ist). Da ich keine Speicherkarte in der Kamera hatte, habe ich das Bild nicht mehr. Das grobe Absuchen am Kameradisplay selbst hat aber im Wesentlichen das Bild gezeigt, das man auf den Bildern 3 bis 5 erkennen kann. Aber hier scheinen doch teilweise auch schon definitiv mehrere benachbarte Pixel stuck bzw. hot zu sein, oder (also etwa die roten Ansammlungen auf dem letzten Bild)?

...

Nein, das ist nicht die 400%-Ansicht, die gibt es nur auf dem PC-Bildschirm.

Die 400%-Ansicht hätte auf deinem PC-Bildschirm erfolgen sollen, da du aber keine Speicherkarte in der Kamera hattest ….

Welche %-Ansicht wird auf dem Display der Sony A7III präsentiert?

Herleitung:

Sensor mit 24,2 MP

Display mit 0,9216 MP (Brutto, für die reine Bildanzeige ist das etwas weniger, siehe Anmerkung unten)

x: horizontal

y: vertikal

mit:

MP = x * y

y = x / 1,5 (Seitenverhältnis)

wird:

MP = x * x / 1,5

x = sqrt( MP * 1,5 )

ergibt am Sensor:

x = 6025 Pixel

ergibt am Display:

x = 1176 Pixel

D.h. ein Bildpixel das sich von den umgebenden Pixel unterscheidet muss um den Faktor 5,12 (= x-Sensor / x-Display) bei der Skalierung vergrößert werden, sonst wird es verschluckt.

Eine 100%-Ansicht auf dem Display

erfordert eine Vergrößerung von = 6025 / 1176 = 5,12.

Die 11,7-fache Vergrößerung auf den Display wäre dann ca. einer 230%-Ansicht.

Die 5,9-fache (Sony) Vergrößerung wird vermutlich die echte 100%-Ansicht sein.

Die 11,7-fache (Sony) Vergrößerung wäre dann dann eine echte 200%-Ansicht.

Anmerkung: Es wird nicht das komplette Display für die Bildanzeige verwendet, links und rechts werden am schwarzen Rand Kameraeinstellungen angezeigt. Die Anzahl der MP für die Bilddarstellung ist also etwas kleiner als 0,916 MP.

Die Hotpixel (nicht die Stuckpixel) bei Langzeitbelichtung ohne Rauschunterdrückung in den Bilder 3-5 sind für die Fotografie mit kurzen Belichtungszeiten, also kürzer als 1s bedeutungslos. Für längere Belichtungszeiten ist die Langzeitrauschunterdrückung da, alternativ ein separates Dunkelbild mit gleicher ISO, Zeit und Temperatur.

Die Stuckpixel in den Aufnahmen 1 und 2 haben die Größe wie ich sie auch schon gesehen habe - ohne allerderdngs weiter darüber nachzudenken.

Exif-DatenMoiré1_362%.jpg126,3 KB · Aufrufe: 26

Exif-DatenMoiré1_362%.jpg126,3 KB · Aufrufe: 26 Exif-DatenMoiré2_362%.jpg153,6 KB · Aufrufe: 25

Exif-DatenMoiré2_362%.jpg153,6 KB · Aufrufe: 25