edgarwallace

Themenersteller

Hallo zusammen,

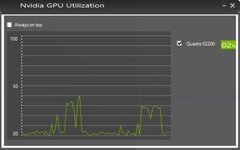

ich hab mal eine Frage, die mich schon lange beschäftigt und die ich mir nicht wirklich beantworten kann. Warum ist Lightroom Classic so lahm?

Vor zwei Jahren habe ich mir ein neues MacBook Pro gekauft, welches eigentlich genug Leistung haben sollte. Ich hab einen 2,6 GHz Quad-Core Intel Core i7 mit 16 GB RAM, SSD-Speicher und einer Radeon Pro 460 4 GB. Tatsächlich war mein altes MacBook nicht unwesentlich schlechter. Lediglich waren die Komponenten der Zeit entsprechend älter. Ich hatte mir eigentlich nach dem Wechsel mehr erhofft, aber LRC ist nicht wesentlich performanter geworden. Ich frage mich, warum, bzw. was ich tun oder kaufen könnte, damit es besser läuft.

Ich bin Berufsfotograf und arbeite sowohl mit Raws, also auch JPEGS (Sony a7III). Die Dateien sind nicht klein, keine Frage, aber es reicht schon wenn ich diese nur bearbeite und mein über einen externen Monitor laufende ZDF Mediathek fängt an leicht zu ruckeln. Ganz schlimm ist es, wenn ich Bilder importiere/rendere oder exportiere. Das lastet die CPU und auch den RAM locker zu 75-90% aus. Einfaches Internetsurfen läuft dann nicht mehr geschmeidig. Wenn ich zwei Ordner aus Lightroom gleichzeitig exportiere ist Schicht im Schacht. Das nervt einfach und ich frage mich, ob mein System das Nadelöhr ist, was ich dann mehr bräuchte um diese Hänger zu beheben oder ob Lightroom einfach nicht besonders "sparsam" arbeitet. Ich bin drauf und dran, einen konfigurierten PC zu kaufen, weil ich hier einfach viel mehr Leistung für kleineres Geld bekomme. Nichts gegen Apple, im Gegenteil, aber 10000 Euro für einen sehr flotten iMac hab ich nicht. Zur Erklärung: Einen Office-PC oder Mac neben meinem MacBook plane ich schon länger.

Nun hoffe ich auf antworten von euch. Vielen Dank schonmal.

ich hab mal eine Frage, die mich schon lange beschäftigt und die ich mir nicht wirklich beantworten kann. Warum ist Lightroom Classic so lahm?

Vor zwei Jahren habe ich mir ein neues MacBook Pro gekauft, welches eigentlich genug Leistung haben sollte. Ich hab einen 2,6 GHz Quad-Core Intel Core i7 mit 16 GB RAM, SSD-Speicher und einer Radeon Pro 460 4 GB. Tatsächlich war mein altes MacBook nicht unwesentlich schlechter. Lediglich waren die Komponenten der Zeit entsprechend älter. Ich hatte mir eigentlich nach dem Wechsel mehr erhofft, aber LRC ist nicht wesentlich performanter geworden. Ich frage mich, warum, bzw. was ich tun oder kaufen könnte, damit es besser läuft.

Ich bin Berufsfotograf und arbeite sowohl mit Raws, also auch JPEGS (Sony a7III). Die Dateien sind nicht klein, keine Frage, aber es reicht schon wenn ich diese nur bearbeite und mein über einen externen Monitor laufende ZDF Mediathek fängt an leicht zu ruckeln. Ganz schlimm ist es, wenn ich Bilder importiere/rendere oder exportiere. Das lastet die CPU und auch den RAM locker zu 75-90% aus. Einfaches Internetsurfen läuft dann nicht mehr geschmeidig. Wenn ich zwei Ordner aus Lightroom gleichzeitig exportiere ist Schicht im Schacht. Das nervt einfach und ich frage mich, ob mein System das Nadelöhr ist, was ich dann mehr bräuchte um diese Hänger zu beheben oder ob Lightroom einfach nicht besonders "sparsam" arbeitet. Ich bin drauf und dran, einen konfigurierten PC zu kaufen, weil ich hier einfach viel mehr Leistung für kleineres Geld bekomme. Nichts gegen Apple, im Gegenteil, aber 10000 Euro für einen sehr flotten iMac hab ich nicht. Zur Erklärung: Einen Office-PC oder Mac neben meinem MacBook plane ich schon länger.

Nun hoffe ich auf antworten von euch. Vielen Dank schonmal.