Spetsnaz

Themenersteller

Ein paar technische Fragen hätte ich:

- Können sich unterschiedliche Dynamikumfänge bereits im .jpg zeigen, obwohl die Dynamik im .jpeg ja generell schon begrenzter ist?

- Was bringt eigentlich mehr Dynamikumfang im RAW, wenn das finale Produkt aus dem .jpeg zu Papier gebracht wird. Oder anders: Wenn ich ich ein .jpeg so abstimme, dass der Dynamikumfang vermeintlich zur Geltung kommt (mehr Zeichnung im Bereich xy), verliere ich doch im Zweifel Daten in einem anderen Bereich, da der Dynamikumfang des Dateiformates beschränkter ist.

- Welche technischen Eigenschaften benötigt ein Ausgabemedium um einen höheren Dynamikumfang tatsächlich zur Geltung zu bringen?

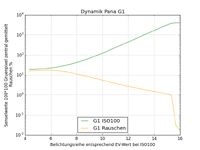

- Wie hängt Rauschen und Dynamik genau zusammen oder anders herum: Eine Ur-Alpha 7 hat einen relativ hohen Dynamikumfang, rauscht aber im Vergleich mit ähnlichen Modellen mehr. Eine 6D hat z.B. einen geringeren Dynamikumfang, soll aber relativ wenig rauschen. Wäre sie damit beim vielzitierten "hochziehen von Schatten" damit generell im Nachteil? Was kommt also beim "geringen Rauschen in dunklen Bildpartien" eher zum Tragen: Mehr Dynamik oder ein besseres Rauschverhalten?

Im Voraus Danke!

- Können sich unterschiedliche Dynamikumfänge bereits im .jpg zeigen, obwohl die Dynamik im .jpeg ja generell schon begrenzter ist?

- Was bringt eigentlich mehr Dynamikumfang im RAW, wenn das finale Produkt aus dem .jpeg zu Papier gebracht wird. Oder anders: Wenn ich ich ein .jpeg so abstimme, dass der Dynamikumfang vermeintlich zur Geltung kommt (mehr Zeichnung im Bereich xy), verliere ich doch im Zweifel Daten in einem anderen Bereich, da der Dynamikumfang des Dateiformates beschränkter ist.

- Welche technischen Eigenschaften benötigt ein Ausgabemedium um einen höheren Dynamikumfang tatsächlich zur Geltung zu bringen?

- Wie hängt Rauschen und Dynamik genau zusammen oder anders herum: Eine Ur-Alpha 7 hat einen relativ hohen Dynamikumfang, rauscht aber im Vergleich mit ähnlichen Modellen mehr. Eine 6D hat z.B. einen geringeren Dynamikumfang, soll aber relativ wenig rauschen. Wäre sie damit beim vielzitierten "hochziehen von Schatten" damit generell im Nachteil? Was kommt also beim "geringen Rauschen in dunklen Bildpartien" eher zum Tragen: Mehr Dynamik oder ein besseres Rauschverhalten?

Im Voraus Danke!