Mirco2706

Themenersteller

Hallo

Ich hätte folgende Frage an euch:

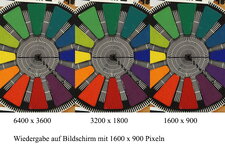

Angenommen, ich habe ein Display (Monitor, TV Gerät oder was auch immer) mit sagen wir mal, 2000*1000 Pixel und ein Foto in der gleichen Auflösung. Nun kann dieses ja in 100% Ansicht im Display angezeigt werden. Jetzt habe ich noch ein Foto mit 4000*2000 Pixeln. Dieses braucht dann ja nur zu 50% angezeigt werden, um das Display zu füllen.

Jetzt interessiert mich folgendes: Mehr Pixel gleich mehr Auflösung, das ist klar. Aber, wäre das höher aufgelöste Foto von der Ansicht her besser oder feiner? Denn es hat ja noch Reserve oder macht das bei der Betrachtung keinen Unterschied? Sondern nur beim Druck?

Danke, Mirco

Ich hätte folgende Frage an euch:

Angenommen, ich habe ein Display (Monitor, TV Gerät oder was auch immer) mit sagen wir mal, 2000*1000 Pixel und ein Foto in der gleichen Auflösung. Nun kann dieses ja in 100% Ansicht im Display angezeigt werden. Jetzt habe ich noch ein Foto mit 4000*2000 Pixeln. Dieses braucht dann ja nur zu 50% angezeigt werden, um das Display zu füllen.

Jetzt interessiert mich folgendes: Mehr Pixel gleich mehr Auflösung, das ist klar. Aber, wäre das höher aufgelöste Foto von der Ansicht her besser oder feiner? Denn es hat ja noch Reserve oder macht das bei der Betrachtung keinen Unterschied? Sondern nur beim Druck?

Danke, Mirco

Als hätte ich bei beiti abgeschrieben!

Als hätte ich bei beiti abgeschrieben!