rob70

Themenersteller

Hallo liebe Experten,

ich möchte das Auflösungsvermögen meiner Objektive selbst testen. Wie es grundsätzlich funktioniert ist mir nach einigem Lesen schon (mehr oder weniger) klar:

Testchart(s) fotografieren. Deren Auflösungs-Umrechnung kennen und mit dem Vergrößerungsfaktor (= Abstand/Brennweite) multiplizieren. Stimmt das so weit (ich hoffe schon)?

Aufbau ist klar, auch die Tipps zur Beleuchtung, zum Stativ, Auslösen, etc. habe ich schon verinnerlicht.

Ich habe nun auch schon einige Testbilder geschossen. Mein Problem ist folgendes:

Ich habe mit dem USAF-Chart gearbeitet und Bilder davon gemacht. Die Frage ist nun die: Wie kann ich beurteilen, welches die letzte Gruppe ist, die noch aufgelöst ist. Die Beispiele im Internet passen nicht zu meinen Ergebnissen. Die Internetbeispiele, die ich gefunden habe, sind alle auf Film gemacht.

Bei mir ist es anders:

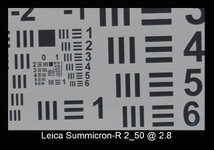

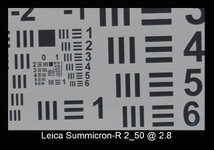

Im Grenzbereich wird keine Linie mehr aufgelöst, sondern z.B. 3 Punkte im Bereich der Linie, so dass im Prinzip ein Unterschied schwarz/weiß aufgelöst wird, nur nicht in Form einer durchgezogenen Linie. Das sieht dann z.B. so aus (bitte noch etwas vergrößern und dann Gruppe 0, Elemente 5 und 6 betrachten):

In diesem Beispiel sehe ich in Gruppe 0, Element 5 vertikal: 3 Punkte statt eines Balken, ebenso in Gruppe 0, Element 6 horizontal.

Gilt das dann noch als aufgelöst, oder muss ein durchgehender Balken zu sehen sein? Gruppe 0, Element 6 horizontal sind die 3 Linien z.B. eindeutig nicht mehr aufgelöst.

Hat das evtl. etwas mit den Sensorpixeln zu tun?

VG, Rolf

ich möchte das Auflösungsvermögen meiner Objektive selbst testen. Wie es grundsätzlich funktioniert ist mir nach einigem Lesen schon (mehr oder weniger) klar:

Testchart(s) fotografieren. Deren Auflösungs-Umrechnung kennen und mit dem Vergrößerungsfaktor (= Abstand/Brennweite) multiplizieren. Stimmt das so weit (ich hoffe schon)?

Aufbau ist klar, auch die Tipps zur Beleuchtung, zum Stativ, Auslösen, etc. habe ich schon verinnerlicht.

Ich habe nun auch schon einige Testbilder geschossen. Mein Problem ist folgendes:

Ich habe mit dem USAF-Chart gearbeitet und Bilder davon gemacht. Die Frage ist nun die: Wie kann ich beurteilen, welches die letzte Gruppe ist, die noch aufgelöst ist. Die Beispiele im Internet passen nicht zu meinen Ergebnissen. Die Internetbeispiele, die ich gefunden habe, sind alle auf Film gemacht.

Bei mir ist es anders:

Im Grenzbereich wird keine Linie mehr aufgelöst, sondern z.B. 3 Punkte im Bereich der Linie, so dass im Prinzip ein Unterschied schwarz/weiß aufgelöst wird, nur nicht in Form einer durchgezogenen Linie. Das sieht dann z.B. so aus (bitte noch etwas vergrößern und dann Gruppe 0, Elemente 5 und 6 betrachten):

In diesem Beispiel sehe ich in Gruppe 0, Element 5 vertikal: 3 Punkte statt eines Balken, ebenso in Gruppe 0, Element 6 horizontal.

Gilt das dann noch als aufgelöst, oder muss ein durchgehender Balken zu sehen sein? Gruppe 0, Element 6 horizontal sind die 3 Linien z.B. eindeutig nicht mehr aufgelöst.

Hat das evtl. etwas mit den Sensorpixeln zu tun?

VG, Rolf