Hi Stuessi,

danke, das sich wenigsten einer mit dem Thema

inhaltlich beschäftigt hat.

Hast Du Blitzbeleuchtung verwendet?

Nein. Alle Bilder wurden bei Tageslicht im Freien, ohne direktes Sonnenlicht aufgenommen. Mit Stativ und Fernauslösung. Bei der Nikon und der Canon mit Spiegelvorauslösung.

Wurde bei jeder Blende (mehrmals) neu fokussiert?

Nein, aus Zeitgründen habe ich nur bei jedem zweiten Blendenwert neu fokussiert bzw. kontrolliert. Und zwar manuell (bei der X-T20 per Focuszoom). Ich muss aber sagen, dass da nur "gefühlt" was nachzustellen war.

Werde das zukünftig aber via HDMI auf einen großen Monitor führen. Mal sehen, ob das mehr bringt.

Sind die Ergebnisse reproduzierbar?

Ja, im Rahmen der Messgenauigkeit. Da das Verfahren nicht automatisiert und 100% objektiv abläuft, ist "etwas Gefühl" gefragt um den Kreisdurchmesser wirklich gut zu bestimmen.

Besonders dann, wenn die horizontale und die vertikale Auflösung unterschiedlich sind. Ich habe mich dann immer mit dem Unschärfekreis sehr konservativ verhalten.

Mit ein wenig Übung hat man aber schnell raus, wie der Unschärfekreis zu legen ist. Und man kann das dann gut reproduzieren. Aber der Faktor Mensch bleibt!!!!

Mir geht es aber dabei auch nicht um den absoluten Wert, sondern um den Trend und den groben Vergleich.

Zum Text nur einige Anmerkungen:

Vor der Formel taucht "PW", in der Formel ohne Kommentierung "PH" auf. Das ist etwas verwirrend.

Ja, sorry Tippfehler. Habe das im Originaltext schon berichtigt.

In der Grafik ist dann einfach von "normiert" die Rede.

Da hätte ich etwas mehr Erläuterung erwartet, z.B.

Wenn auf jede weiße oder schwarze Linie des Siemensstern genau 1 Pixel kommt beträgt die Auflösung 100%.

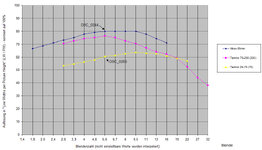

Dividiert man also die Linienzahl 2*NS des Sterns durch die Pixelzahl des Kreisumfangs, so erhält man direkt den normierten Wert.

[ (2 * NS ) / ({Durchmesser in Pixeln} * Pi) ] * 100%

Ja, ist im Prinzip OK so.

Ich bin aber anders vorgegangen. Mein Siemensstern hat in der Mitte keinen 1-Pixel-Punkt, sondern einen Mittelpunktkreis auf den die Linien hin laufen.

Der ist bei meinen Nikon-Bildern z.B. 84 Pixel und bei der Fuji etwa 70 Pixel im Durchmesser. Hängt auch etwas davon ab, wie man das Chart im Vollbild getroffen hat. Die 84 Pixel bzw. 70 Pixel habe ich in "Line Widths per Picture Height" umgerechnet und den Wert zu 100% gesetzt. Alle anderen Werte beziehen sich auf die max. zu erreichenden Auflösung (beim Mittelpunktkreis von z.B. 84 Pixels).

Werde das bei Gelegenheit im EDV-TIPP ergänzen.

Der Unterschied zwischen "Pentacon auto 1.8 50mm" bzw. "Canon FD 50mm 1:1.4" ist merkwürdig. Der Erklärungsversuch überzeugt mich auch nicht.

Ja, so ist die Welt. Ich hatte auch nicht den Anspruch Dich zu überzeugen. Ich kann nur aufzeigen, was ich bei meinen Objektiven mit einer bestimmten Kamera gemessen habe und wer kennt nicht den alten Spruch "Wer viel misst, misst viel Mist". Ich bin da ganz schmerzfrei, aber nicht beratungsresistent. ;-)

Also, es geht mir nicht um absolute Zahlen, sondern um das "Verfahren für den Hausgebrauch" und um sich damit Gedanken über Schärfe zu machen. So Antworten wie hier

https://www.dslr-forum.de/showthread.php?t=429784 fand ich wenig hilfreich.

Heute habe ich einen (einmaligen) Vergleich zwischen dem Canon Objektiv und einem Sony Kit Objektiv an der A6000 gemacht und nach Deinem Vorschlag, (...) ausgewertet.

Hast Du mit DCRaw die Graustufenbilder isoliert?

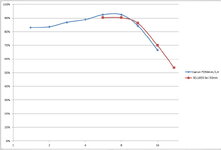

Was mir bei Dir gut gefällt, ist die lineare Darstellung der Blendenstufen. Das ergibt keine so "eckigen" Kurven wie bei mir.

Ich habe aber, um die Unterschiede zwischen den Objektiven größer herauszustellen, den Auflösungsbereich der Y-Achse in der Grafik gespreizt.

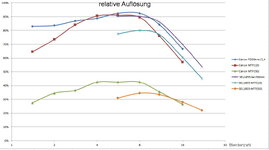

Beim Vergleich meiner Ergebnisse mit Deinen sollte man berücksichtigen, dass die A6000 (Pixelpitch 3,9 µm) weniger hohe Anforderungen an die Objektive stellt als die Fuji X20 (Pixelpitch 2,2 µm). Die Messergebnisse beziehen sich ja immer auf die Kombination Kamera + Objektiv!

Zuerst, wenn ich darf, eine kleine Korrektur: Ich habe die Fuji X-T20. Das ist auch eine APS-C mit Pixel pitch von 3,9 µm/Px (23,6mm/6032Px*1000) Vergleich siehe

hier.

Ja, so ist das aber. Es gibt generell keinen Sinn unterschiedliche Kombinationen übereinander zu legen.

Ich hatte das ansatzweise mit den Messwerten meiner Nikon D810 (Pixel pitch 4,87 µm) gemacht und die Messwerte der Fuji X-T20 drübergelegt. Ist aber meiner Meinung nach nicht zulässig.

das entspricht etwa MTF(10)

Was entspricht "etwa MTF(10)". Wo kommt der Kontrast her in Deiner Überlegung?

Bei einem früheren Vergleich der beiden Objektive war das Canon Objektiv besser als das Pentacon

Da stimme ich Dir zu 100% zu. Die besseren Bilder (mit einem besseren, ja schärferen Gesamteindruck) macht -meiner Meinung nach- in der Tat das Canon und nicht das Pentacon. Das Pentacon ist viel zu flau und ohne jedweden Kontrast, im Vergleich zum Canon. Das siehst Du aber auf den "Graustufenbildern" einer RAW-Aufnahme nicht. ;-)

Darum spreche ich auch nur von Schärfe - nicht von Kontrast. Und damit nicht von MTF!

Grüße

Stefan